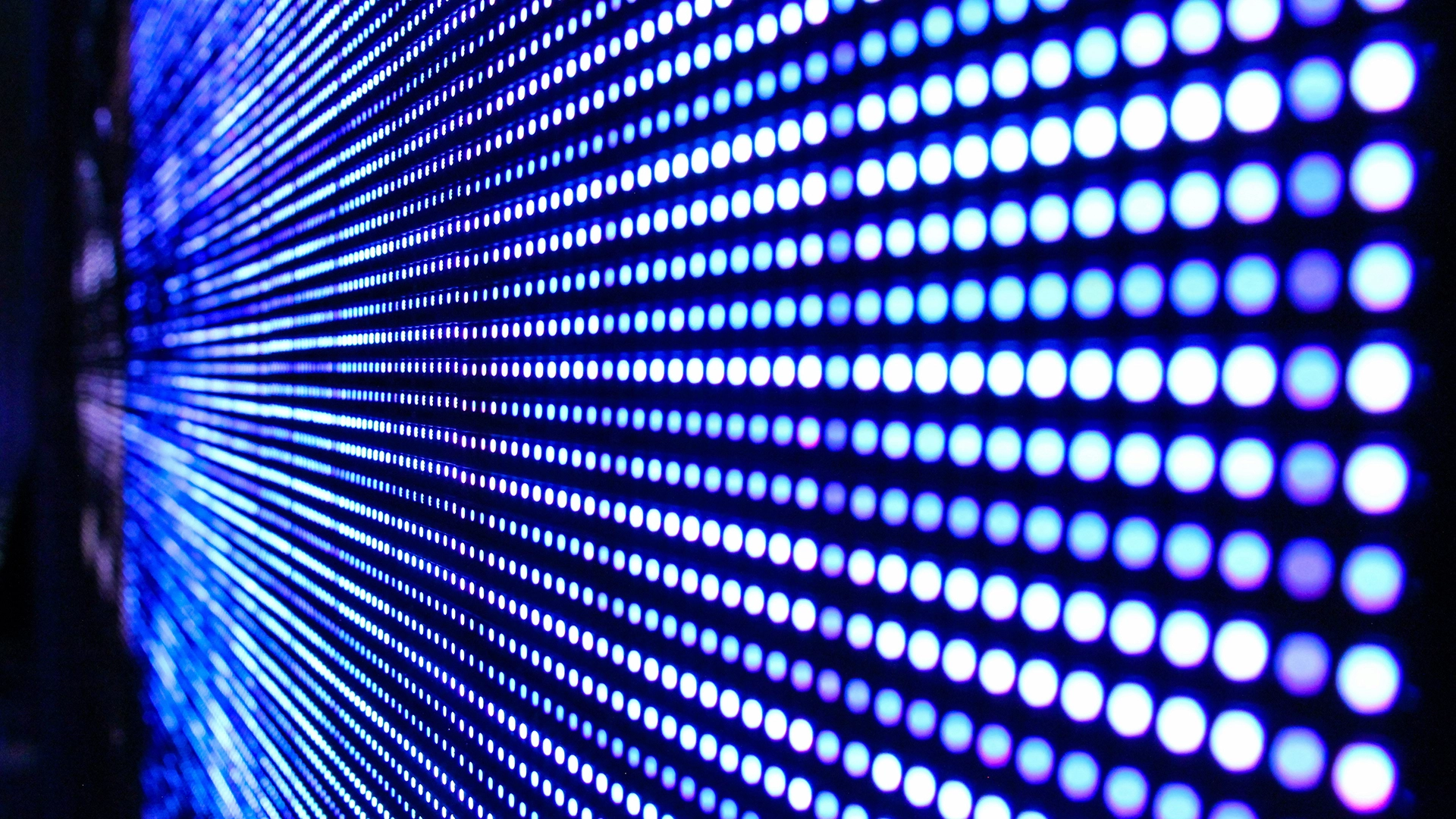

Image by Justin Lane, from Unsplash

Gli Scienziati Nascondono Codici di Luce per Smascherare i Falsi Video di Intelligenza Artificiale

I ricercatori di Cornell hanno sviluppato una nuova tecnologia per aiutare i fact-checkers a rilevare video falsi o manipolati, e lo hanno fatto incorporando filigrane segrete nella luce.

Sei di fretta? Ecco i fatti essenziali:

- Ricercatori di Cornell hanno sviluppato filigrane basate sulla luce per rilevare video falsi o alterati.

- Il metodo nasconde codici segreti in fluttuazioni di luce quasi invisibili.

- Le filigrane funzionano indipendentemente dalla fotocamera utilizzata per registrare le riprese.

I ricercatori spiegano che questo metodo nasconde fluttuazioni quasi invisibili nell’illuminazione durante eventi importanti o in luoghi chiave, come conferenze stampa o interi edifici.

Queste fluttuazioni, impercettibili all’occhio umano, vengono catturate in qualsiasi video girato sotto l’illuminazione speciale, che può essere programmata su schermi di computer, lampade fotografiche o apparecchiature esistenti integrate.

“Il video era considerato una fonte di verità, ma non è più un’assunzione che possiamo fare”, ha detto Abe Davis, professore associato di informatica a Cornell, che ha concepito l’idea.

“Ora puoi praticamente creare un video di qualsiasi cosa tu voglia. Può essere divertente, ma anche problematico, perché diventa sempre più difficile capire cosa sia reale”, ha aggiunto Davis.

Le tecniche tradizionali di watermarking modificano direttamente i file video, richiedendo la cooperazione della fotocamera o del modello AI utilizzato per crearli. Davis e il suo team hanno bypassato questa limitazione incorporando il codice nell’illuminazione stessa, garantendo che qualsiasi video reale del soggetto contenga il watermark nascosto, indipendentemente da chi lo registra.

Ogni luce codificata produce un “video codice” a bassa fedeltà, con data e ora, della scena con illuminazione leggermente diversa. “Quando qualcuno manipola un video, le parti manipolate iniziano a contraddire quello che vediamo in questi video codice”, ha spiegato Davis.

“E se qualcuno prova a generare un falso video con l’IA, i video codice risultanti sembrano solo delle variazioni casuali”, ha aggiunto Davis.

Il capoprogetto Peter Michael ha spiegato che il team ha creato codici di luce impercettibili attingendo alla ricerca sulla percezione umana. Il sistema utilizza i normali schemi di “rumore” della luce per rendere difficile la rilevazione senza la chiave segreta. Le luci programmabili possono essere codificate con un software, mentre le lampade più vecchie possono utilizzare un piccolo chip delle dimensioni di un francobollo.

Il team è riuscito a implementare con successo fino a tre codici separati per diverse luci all’interno della stessa scena, il che aumenta significativamente la difficoltà di falsificarli. Il sistema ha dimostrato la sua efficacia all’aperto e su vari toni di pelle.

Tuttavia, Davis avverte che la lotta contro la disinformazione è tutt’altro che finita. “Questo è un problema importante e costante”, ha detto. “Non sparirà, anzi, diventerà solo più difficile.”

Storia precedente

Storia precedente

Ultimi articoli

Ultimi articoli