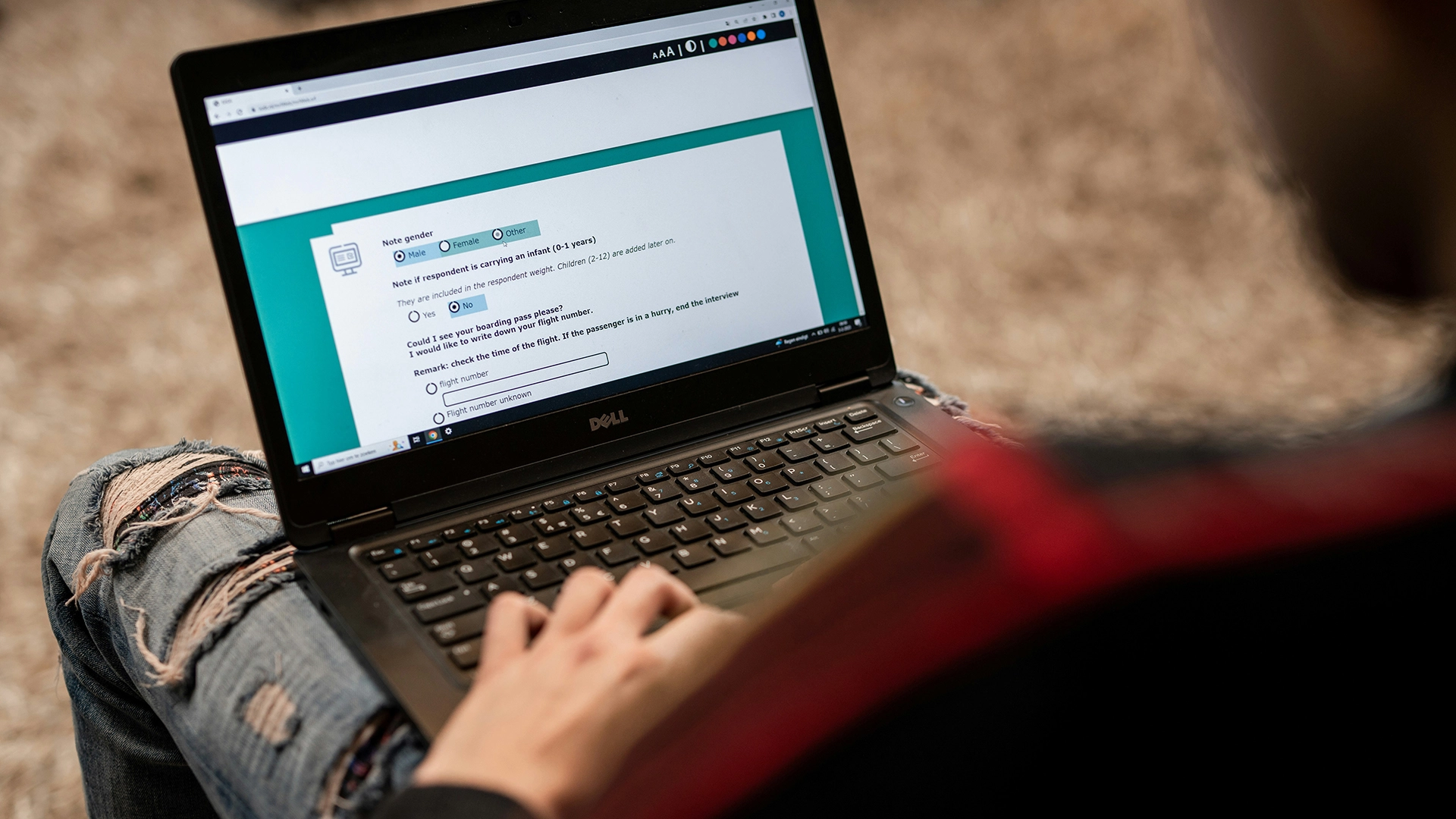

Image by ODISSEI, from Unsplash

Quasi la Metà delle Risposte ai Sondaggi Online Potrebbe Provenire da AI, Rivela uno Studio

La ricerca comportamentale online, che in precedenza era considerata un metodo affidabile per lo studio della psicologia umana, ora si scontra con un grande problema poiché i partecipanti utilizzano strumenti di intelligenza artificiale come i chatbot per generare le loro risposte.

Sei di fretta? Ecco i fatti essenziali:

- Il 45% dei partecipanti ai sondaggi di Prolific ha incollato risposte generate dall’IA.

- I ricercatori hanno scoperto che il testo del chatbot spesso sembrava “eccessivamente verboso” o “non umano”.

- Gli esperti definiscono il problema come “Inquinamento LLM”, minacciando la validità della ricerca comportamentale.

Ricercatori presso l’Istituto Max Planck per lo Sviluppo Umano a Berlino hanno recentemente indagato quanto sia diffuso il problema su piattaforme come Prolific, che paga i volontari per completare i sondaggi.

“Le percentuali di incidenza che stavamo osservando erano davvero scioccanti”, afferma la ricercatrice principale Anne-Marie Nussberger, come riportato da New Scientist (NS).

In un test, il 45 per cento dei partecipanti sembrava incollare contenuti generati da chatbot in un campo di risposta aperto. Le risposte mostravano spesso segni come un linguaggio “eccessivamente verboso” o “distintamente non umano”.

“Dai dati che abbiamo raccolto all’inizio di quest’anno, sembra che una consistente proporzione di studi sia contaminata”, ha detto Nussberger a NS.

Per rilevare risposte sospette, il suo team ha introdotto trappole nascoste. I reCAPTCHA di base hanno segnalato lo 0,2 per cento degli utenti, una versione più avanzata ne ha catturato il 2,7 per cento, un prompt di testo invisibile che chiedeva la parola “nocciola” ha intrappolato l’1,6 per cento, e il divieto di copia-incolla ha rivelato un altro 4,7 per cento.

Il problema si è evoluto in quello che gli esperti ora chiamano “Inquinamento da LLM”, che si estende oltre il semplice barare. Lo studio di ricerca rivela tre schemi di interferenza dell’IA: Mediazione Parziale (l’IA assiste con la formulazione o la traduzione), Delega Completa (l’IA svolge studi completi), e Spillover (gli esseri umani modificano le loro azioni perché anticipano la presenza dell’IA).

“Quello che dobbiamo fare non è diffidare completamente della ricerca online, ma rispondere e reagire,” dice Nussberger, invitando le piattaforme a prendere sul serio il problema, come riportato da NS..

Matt Hodgkinson, un consulente per l’etica della ricerca, mette in guardia NS: “L’integrità della ricerca comportamentale online era già sotto sfida […] I ricercatori devono o trovare collettivamente dei metodi per verificare a distanza il coinvolgimento umano o tornare al vecchio approccio del contatto faccia a faccia.”

Prolific ha rifiutato di commentare a NS.

Storia precedente

Storia precedente

Ultimi articoli

Ultimi articoli