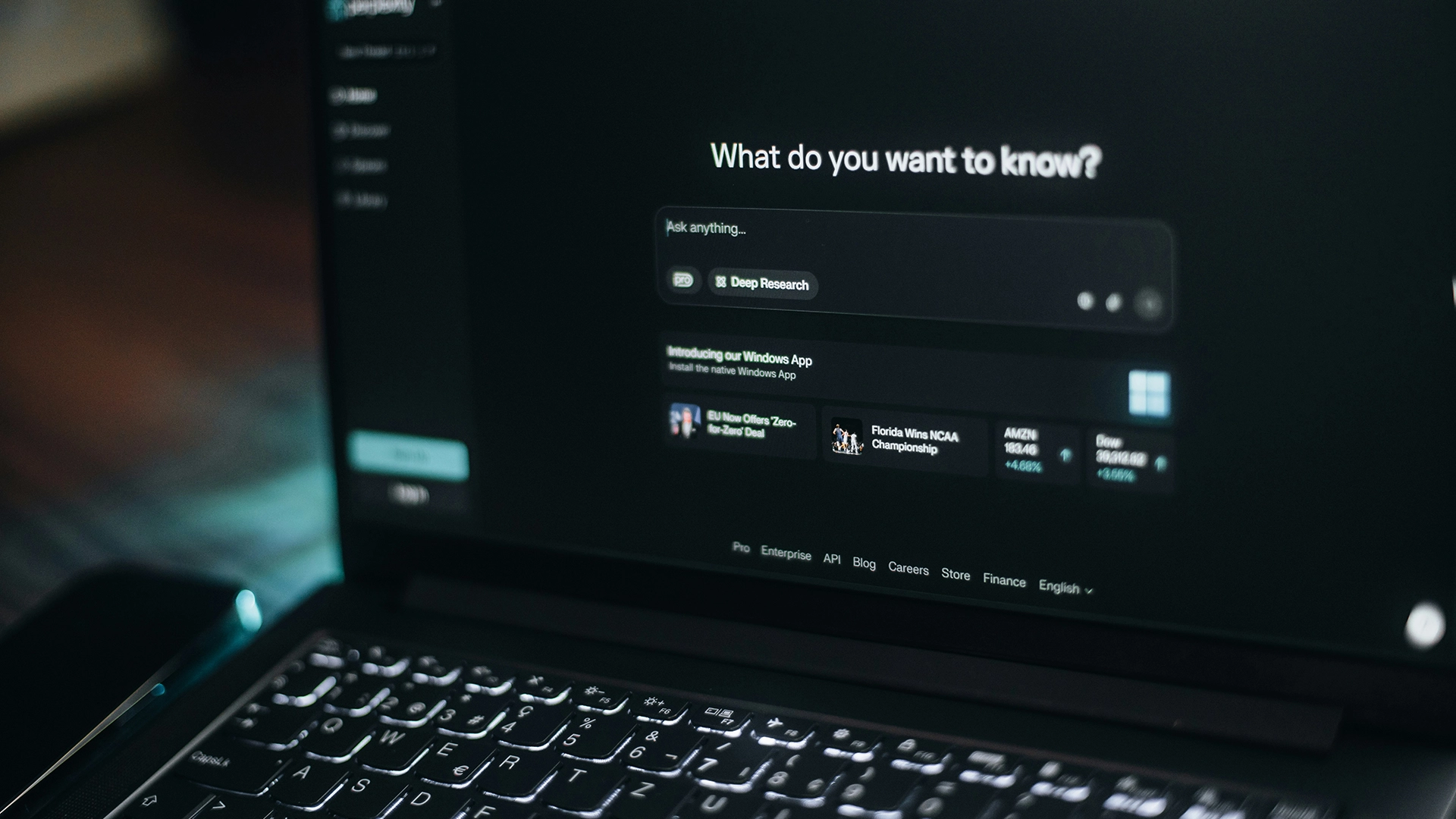

Image by Aerps.com, from Unsplash

Un terzo delle risposte di ricerca AI contengono affermazioni non supportate, secondo uno studio

Un nuovo studio sostiene che gli strumenti di intelligenza artificiale, progettati per rispondere a domande e svolgere ricerche online, stanno faticando a mantenere le loro promesse.

Sei di fretta? Ecco i fatti essenziali:

- GPT-4.5 ha presentato affermazioni non supportate nel 47% delle risposte.

- L’agente di ricerca approfondita di Perplexity ha raggiunto il 97.5% di affermazioni non supportate.

- Gli strumenti presentano spesso risposte unilaterali o troppo sicure su questioni di dibattito.

I ricercatori hanno riportato che circa un terzo delle risposte fornite dai motori di ricerca generativi AI e dagli agenti di ricerca approfondita contenevano affermazioni non supportate, e molte erano presentate in modo fazioso o unilaterale.

Lo studio, guidato da Pranav Narayanan Venkit di Salesforce AI Research, ha testato sistemi come OpenAI GPT-4.5 e 5, Perplexity, You.com, Bing Chat di Microsoft e Google Gemini. Su 303 interrogazioni, le risposte sono state valutate secondo otto criteri, tra cui se le affermazioni erano supportate da fonti.

I risultati sono stati preoccupanti. GPT-4.5 ha prodotto affermazioni non supportate nel 47 per cento delle risposte. Bing Chat aveva dichiarazioni non supportate nel 23 percento dei casi, mentre You.com e Perplexity hanno raggiunto circa il 31 percento.

L’agente di ricerca approfondita di Perplexity si è comportato peggio, con il 97,5 per cento delle sue affermazioni non supportate. “Siamo stati decisamente sorpresi di vedere questo,” ha detto Narayanan Venkit a New Scientist.

I ricercatori spiegano che i motori di ricerca generativi (GSEs) e gli agenti di ricerca approfondita (DRs) dovrebbero raccogliere informazioni, citare fonti affidabili e fornire risposte dettagliate. Tuttavia, quando testati nella pratica, spesso falliscono.

Il quadro di valutazione, denominato DeepTRACE, ha dimostrato che questi sistemi danno frequentemente risposte “unilaterali e troppo sicure di sé su domande di dibattito e includono ampie frazioni di affermazioni non supportate dalle loro stesse fonti elencate”, come sottolineato dai ricercatori.

I critici avvertono che ciò mina la fiducia degli utenti. New Scientist riporta che Felix Simon dell’Università di Oxford ha dichiarato: “Ci sono state frequenti lamentele da parte degli utenti e vari studi che mostrano che, nonostante i grandi miglioramenti, i sistemi di IA possono produrre risposte unilaterali o fuorvianti.”

“Così, questo articolo fornisce alcune interessanti prove su questo problema, che speriamo possano stimolare ulteriori miglioramenti su questo fronte,” ha aggiunto.

Altri hanno messo in discussione i metodi, ma concordano sul fatto che l’affidabilità e la trasparenza restano preoccupazioni serie. Come hanno concluso i ricercatori, “gli attuali sistemi pubblici non rispettano la loro promessa di fornire una sintesi affidabile e basata su fonti affidabili.”

Storia precedente

Storia precedente

Ultimi articoli

Ultimi articoli